Дата публикации: 19.05.2023

Автор: Тепикина Анастасия,

маркетинговый аналитик компании Editorum

БЛОГ EDITORUM

ChatGPT в практике редакторов научных изданий

Не касаясь философской дискуссии, технологической сингулярности и возможности существовании научного творчества в эпоху нейросетей, рассматриваем практические для редакторов научных журналов вопросы: почему ответы ChatGPT необходимо проверять и можно ли считать ChatGPT автором.

Что такое ChatGPT

Почему ответы ChatGPT необходимо проверять

Можно ли считать ChatGPT автором

Список источников

Нейросеть ChatGPT общается с пользователем на естественном языке. Это так непривычно, что хочется говорить ей «Спасибо».

А она вежливо отвечает и на это

Что такое ChatGPT

ChatGPT — это чат-бот с искусственным интеллектом, разработанный компанией OpenAI. Он был запущен 30 ноября 2022 года, и мгновенно стал очень популярен. 14 марта 2023 года была выпущена последняя на сегодняшний день версия GPT-4.

В основе ChatGPT алгоритм, который научился предугадывать следующее слово в предложении. К этому мы привыкли, так как та же технология используется при наборе сообщений в мобильных телефонах. Отличает ChatGPT колоссальный объем данных, на котором обучалась эта нейросеть, их принципиально новое структурирование, а также качественная модерация данных после обучения.

В результате ChatGPT может поддерживать диалог на любые темы, писать код, стихи и подстраиваться под требования пользователя.

Официально ChatGPT недоступна в России: по решению компании OpenAI, невозможно зарегистрироваться на российский номер. Однако это не помешало студенту РГГУ Александру Жадану написать с помощью ChatGPT диплом, защитить его на тройку, а затем рассказать о своей хитрости в Интернете [1]. Это спровоцировало жаркую дискуссию о необходимости изменения подхода к оценке знаний студентов.

Почему ответы ChatGPT необходимо проверять

ChatGPT не ищет данные в Интернете прямо сейчас. Нейросеть обучалась на данных до 2021 года, поэтому обо всем, что произошло позже, она не знает.

В процессе общения с пользователем система также не обучается. Ее память ограничена 80 000 токенов (единиц текста), после этого она забудет все, о чем вы с ней говорили. Таким образом, ChatGPT не становится умнее от разговоров с пользователями и не подходит для работы над большими текстами.

При этом можно скопировать для нее какой-то текст, и она будет с ним работать, но нужно это сделать самому и помнить, что через 80 000 токенов она о нем забудет.

Нейросеть не задает уточняющие вопросы. Как она интерпретирует запрос — неизвестно. И она не может признаться в том, что чего-то не знает. Она просто выдумает подходящий ответ. Он будет правдоподобным, поэтому отловить такую подмену непросто.

«Нейросеть не может признаться в том, что чего-то не знает.

Она просто выдумает подходящий ответ».

Особенно сложно со ссылками на источники. Можно попросить нейросеть подготовить материал с реальными ссылками, но скорее всего сеть будет выдавать компиляцию из названий журналов, статей и фамилий авторов вместо того, чтобы давать корректные источники.

Таким образом, на сегодняшний день все, написанное ChatGPT, нуждается в проверке.

Подробнее о том, как устроена ChatGPT, можно послушать в подкасте «Запуск завтра» от 9 февраля 2023 года, в котором экспертом выступает Артем Родичев, бывший Head of AI в компании Replika — самого крупного чат-бота в мире [2].

Можно ли считать ChatGPT автором

После запуска ChatGPT прошла волна публикаций, в которых бот был указан соавтором. В Scopus есть страница автора ChatGPT, у которого 3 публикации и 42 цитирования. Присутствует даже ORCID, но он попал туда ошибочно, так как принадлежит ученому из Узбекистана.

Со временем появляется все больше заявлений, что ChatGPT автором не является.

У журналов, выпускаемых Elsevier, в требованиях для авторов появился раздел «Декларация о генеративном ИИ в научном письме» (Declaration of generative AI in scientific writing), где указано, что искусственный интеллект не может быть автором и не может цитироваться как автор, а также, что использование ИИ в работе должно декларироваться в тексте статьи, разъясняться причина использования, и все ответы ИИ должны проверяться и дорабатываться человеком [3].

Авторский профиль ChatGPT в Scopus

Мировая ассоциация медицинских редакторов (WAME) в январе 2023 года опубликовала свои рекомендации на счет ChatGPT и других программ искусственного интеллекта [4]. Они сводятся к 4 пунктам:

1. Чат-боты не могут быть авторами.

2. Авторы должны указывать в статье использовании чат-ботов и предоставлять информацию о том, как они использовались.

3. Авторы несут ответственность за работу, выполненную чат-ботом в своей статье (включая точность изложенного и отсутствие плагиата) и за надлежащее указание всех источников (в том числе материалов, созданных чат-ботом).

4. Редакторам нужны инструменты, которые помогут им обнаруживать контент, созданный или измененный с помощью ИИ.

Аналогичную позицию занимает и Комитет по публикационной этике (COPE), на сайте которого много эссе на эту тему, а также заявление «Авторство и инструменты ИИ», в котором искусственному интеллекту отказано в праве быть автором из-за невозможности нести ответственность за написанное [5].

«COPE: искусственный интеллект не может быть автором

из-за невозможности нести ответственность за написанное».

Если говорить об инструментах обнаружения, 2 мая пользователям системы «Антиплагиат» стал доступен функционал обнаружения текстов, созданных при помощи искусственного интеллекта. Подробнее о том, как он работает, написано в статье «За кулисами интеллекта ChatGPT: рассказ о том, как определяют тексты, созданные ИИ» в блоге компании [6].

Если обратиться к российскому законодательству, то ГК РФ Статья 1257 Гражданского кодекса РФ гласит: «Автором произведения науки, литературы или искусства признается гражданин, творческим трудом которого оно создано». Искусственный интеллект гражданином не является, поэтому с точки зрения закона ответ тоже однозначный: нейросеть не может выступать автором.

Это поднимает еще одну тему: тему отставания законодательства от развития информационных технологий. Нигде в мире еще нет законов, регламентирующих использование искусственного интеллекта [7].

В России действует Кодекс этики в сфере ИИ, разработанный Альянсом в сфере искусственного интеллекта — объединением ведущих компаний, работающих в этой сфере. Кодекс носит рекомендательный характер. Этот кодекс прямо гласит: «Ответственность за последствия применения СИИ всегда несет человек» [8].

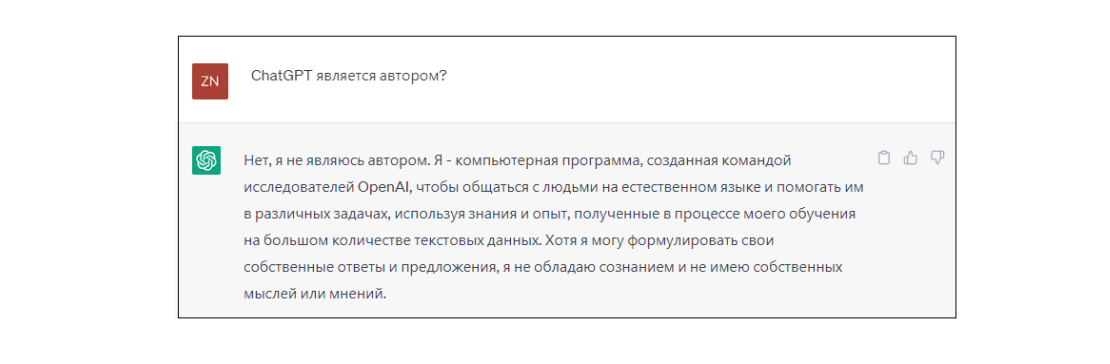

Пример ответа ChatGPT

Примечательно, что сама ChatGPT на вопрос «Является ли ChatGPT автором?» однозначно отвечает: нет, не является.

Таким образом включение ChatGPT в список авторов является нарушением редакционно-издательской этики и противоречит существующим юридическим нормам.

Список источников

1. Жадан А. Как я написал диплом с помощью ChatGPT и оказался в центре спора о нейросетях в образовании // Тинькофф журнал. 22.02.2023 URL: https://journal.tinkoff.ru/neuro-diploma/

2. Родичев, А., Галимов С. ChatGPT. Виртуальный помощник на все случаи жизни. // Запуск Завтра. [Подкаст]. 09.02.2023. URL: https://music.yandex.ru/album/9294155/track/111366340

3. Guide for Authors // Elsevier. URL: https://www.elsevier.com/journals/artificial-intelligence-in-the-life-sciences/2667-3185/guide-for-authors

4. Zielinski Chris, Winker Margaret, Aggarwal Rakesh и др. Chatbots, ChatGPT, and Scholarly Manuscripts: WAME Recommendations on ChatGPT and Chatbots in Relation to Scholarly Publications. January 20, 2023. URL: https://wame.org/page3.php?id=106

5. Authorship and AI tools // COPE position statements. 13.02.2023. URL: https://publicationethics.org/cope-position-statements/ai-author

6. Грицай Г. За кулисами интеллекта ChatGPT: рассказ о том, как определяют тексты, созданные ИИ // Хабр. 10.04.2023. URL: https://habr.com/ru/companies/antiplagiat/articles/728112/

7. Федоренко С. П. Метавселенная как фактор трансформации правового регулирования // Северо-Кавказский юридический вестник. 2023. № 1. С. 56–61. https://doi.org/10.22394/2074- 7306-2023-1-1-56-61

8. Кодекс этики в сфере Искуственного интеллекта. 18 c. URL: https://ethics.a-ai.ru/assets/ethics_files/2023/05/12/%D0%9A%D0%BE%D0%B4%D0%B5%D0%BA%D1%81_%D1%8D%D1%82%D0%B8%D0%BA%D0%B8_20_10_1.pdf

Остались вопросы? Пишите на почту tepikina@editorum.ru , в Telegram-канал или сообщество Вконтакте.